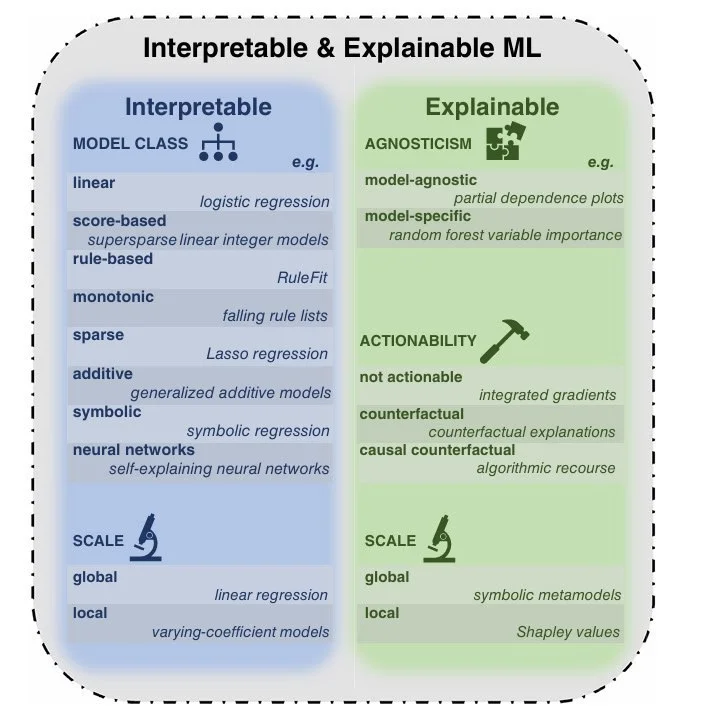

Тут на Хабре вышла отличная статья про объяснимый ИИ (XAI). Если кратко: мы всё чаще используем ИИ в критичных сферах - от медицины до юриспруденции, но до сих пор не понимаем, как они принимают решения :)

Проблема в двух словах:

- ИИ выдаёт brilliant-результаты, но не может внятно объяснить ход мыслей

- Методы вроде LIME, SHAP и контрфактуальных объяснений - это костыли, а не решение

- Регуляторы (типа AI Act в ЕС) уже требуют прозрачности

А я смотрю на это и думаю: мы создали цифрового оракула, который умнее нас, но не способен к рефлексии ... Особенно весело, когда ChatGPT генерит фейковые судебные дела с невозмутимым видом - классика "галлюцинаций" LLM!

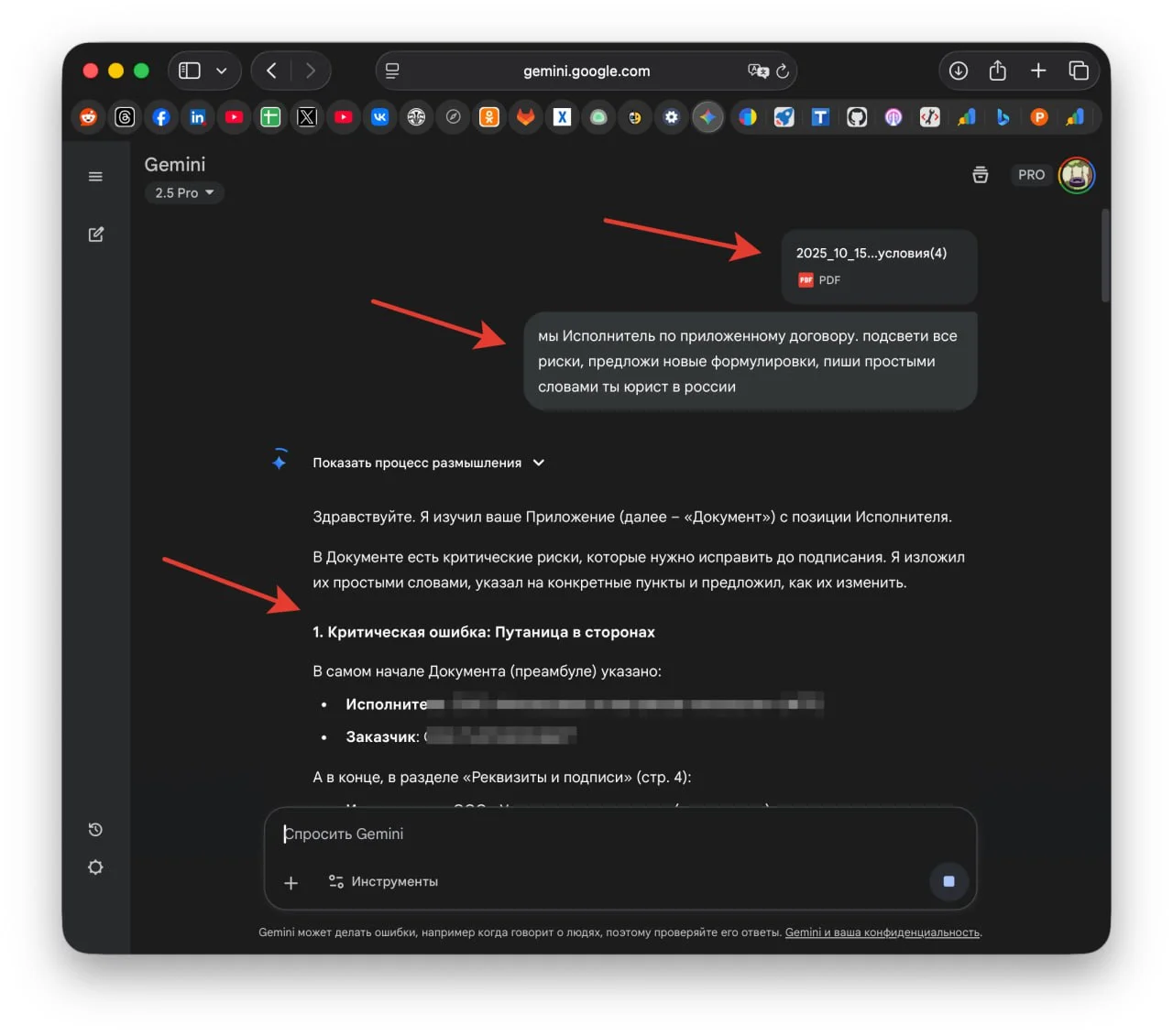

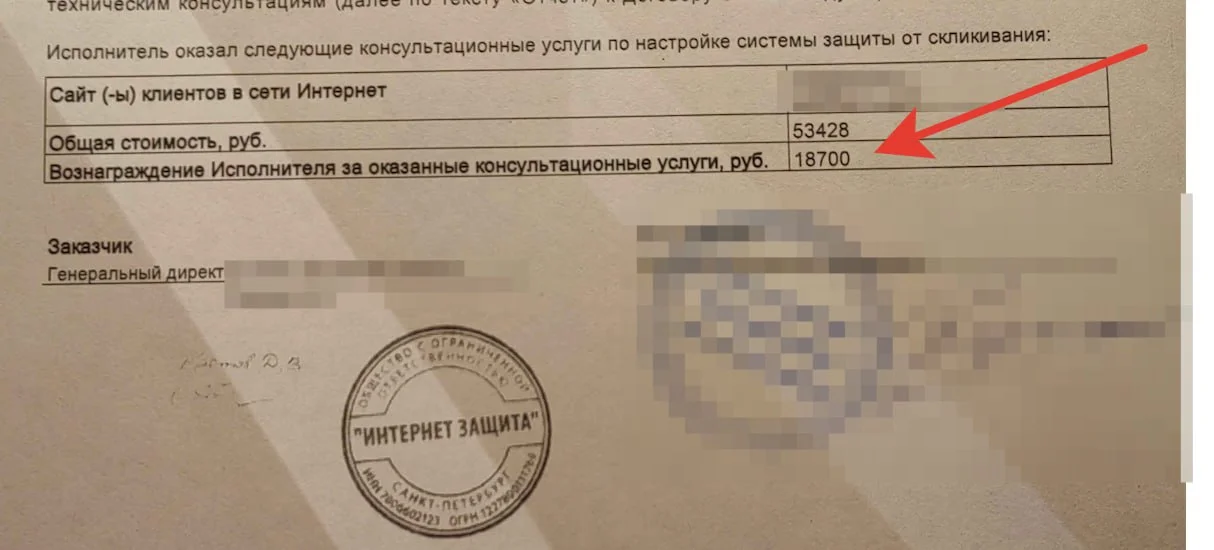

Но договора ИИ неплохо анализирует, тут признаю.

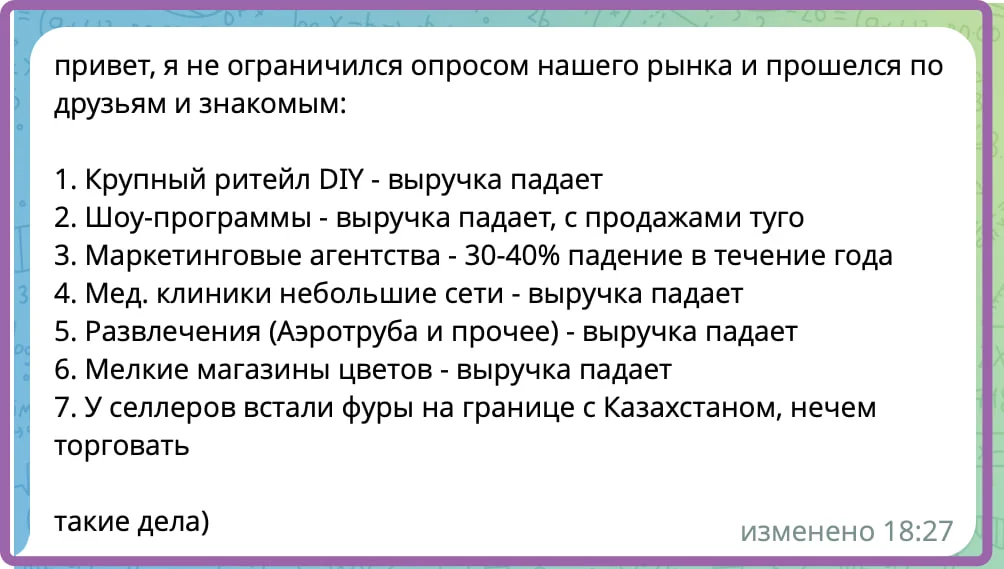

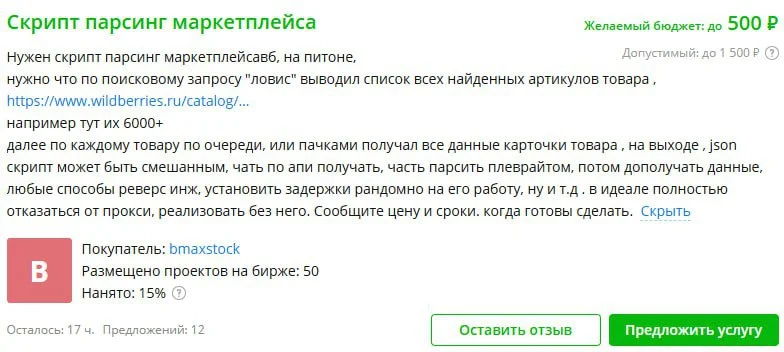

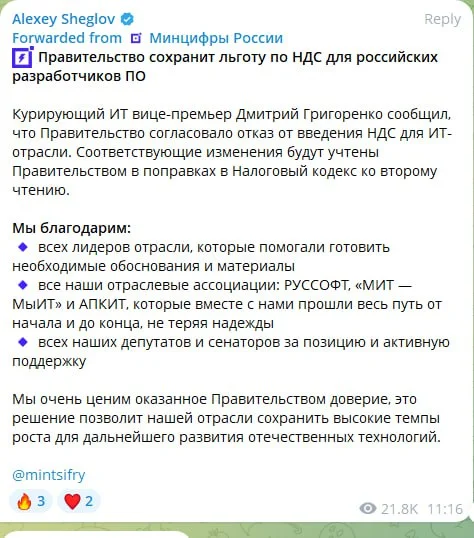

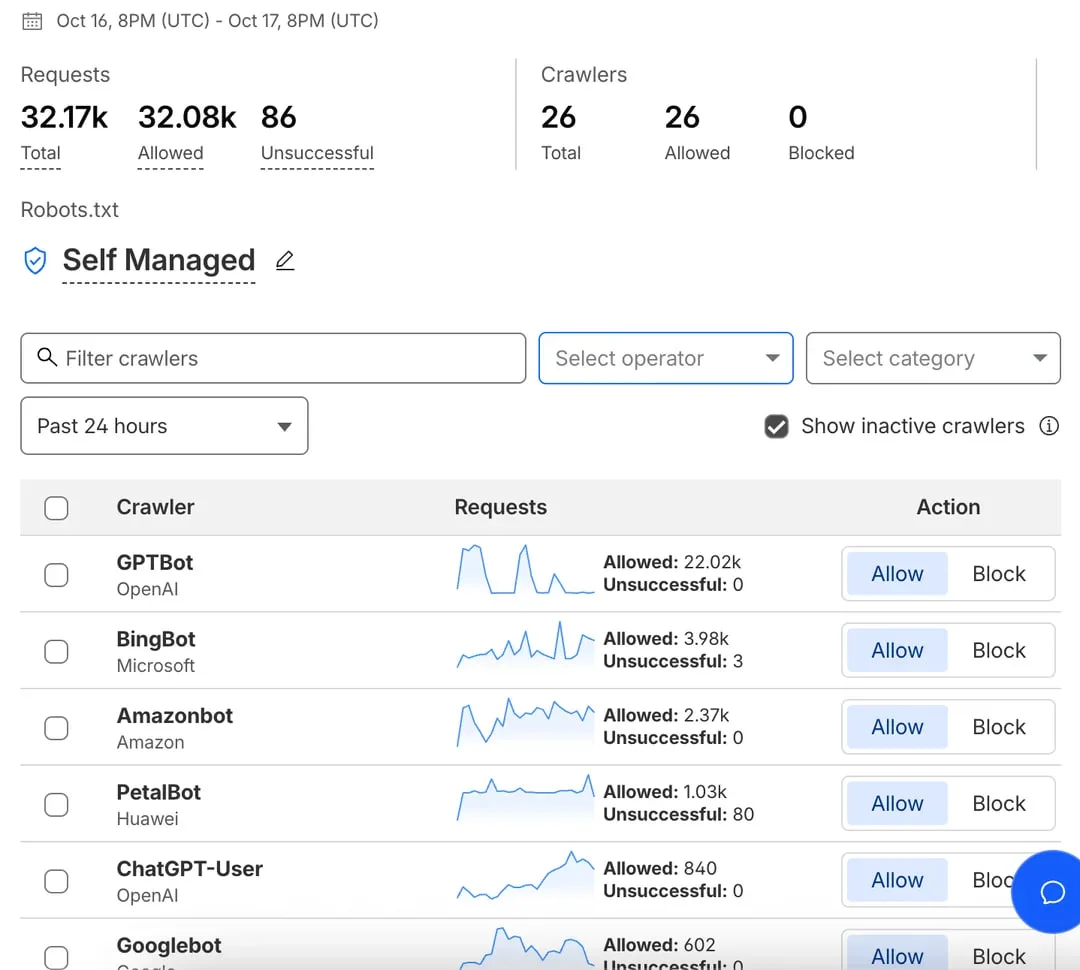

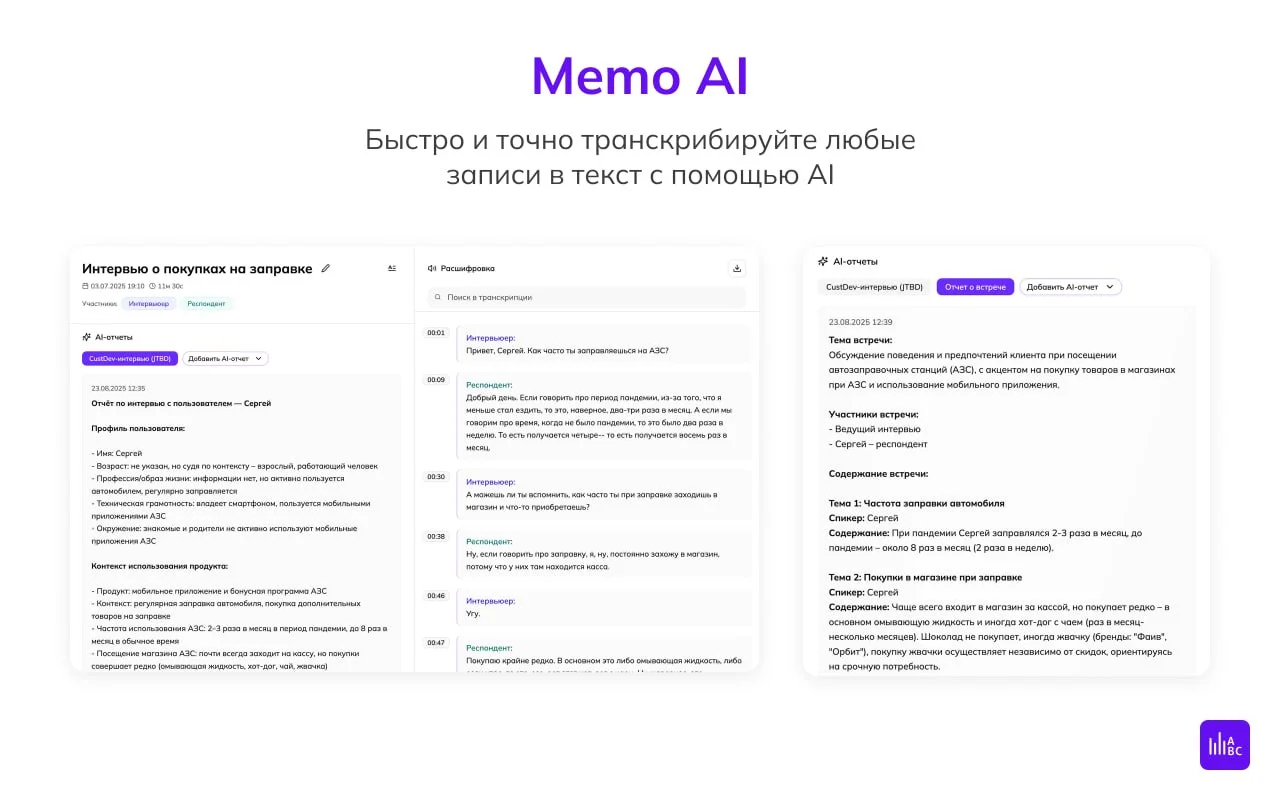

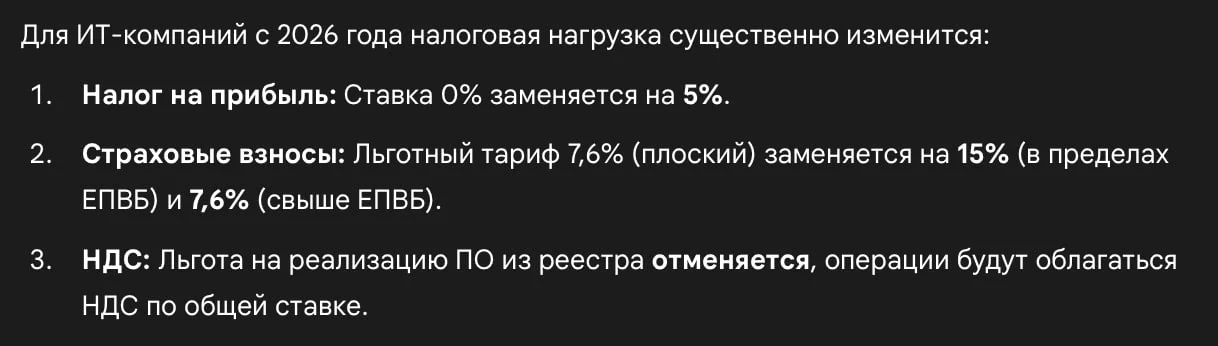

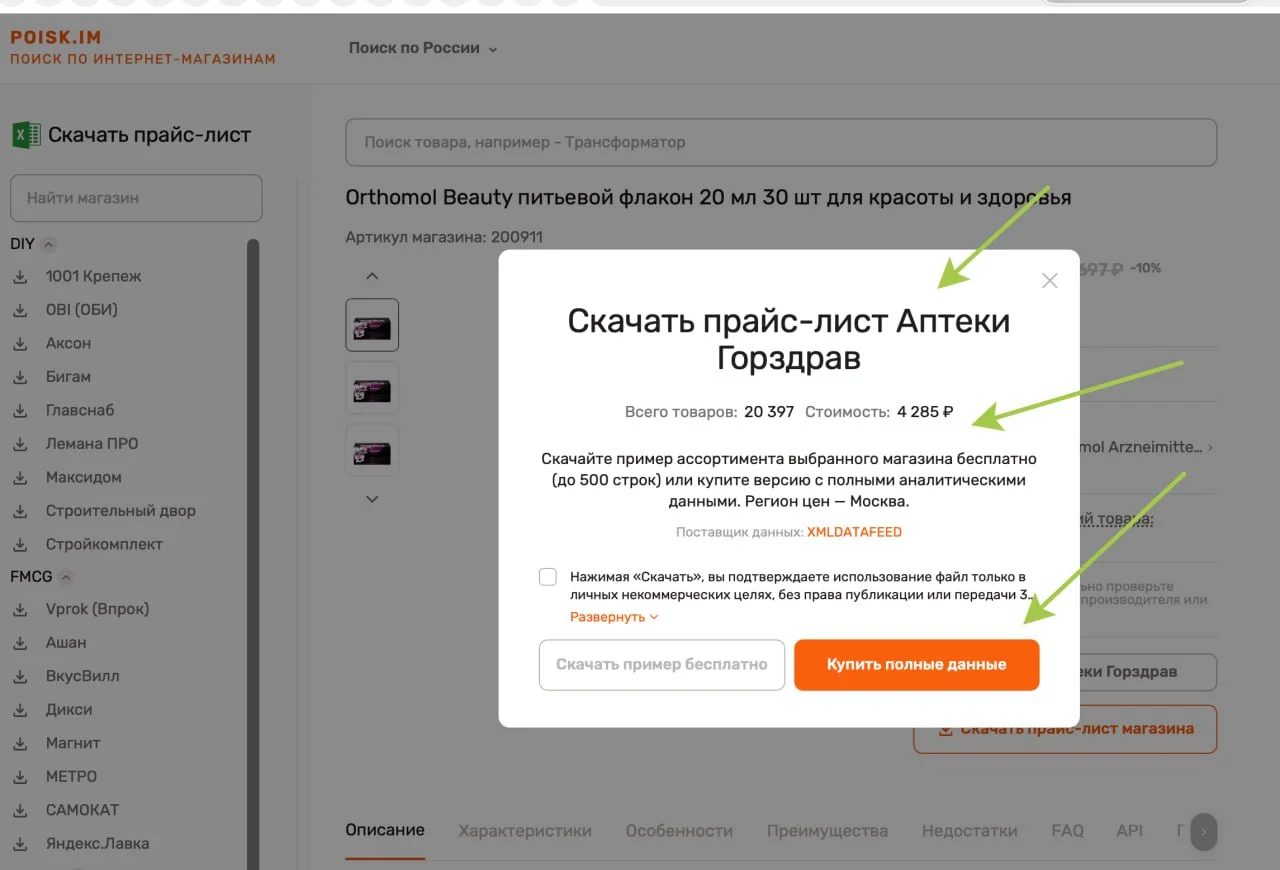

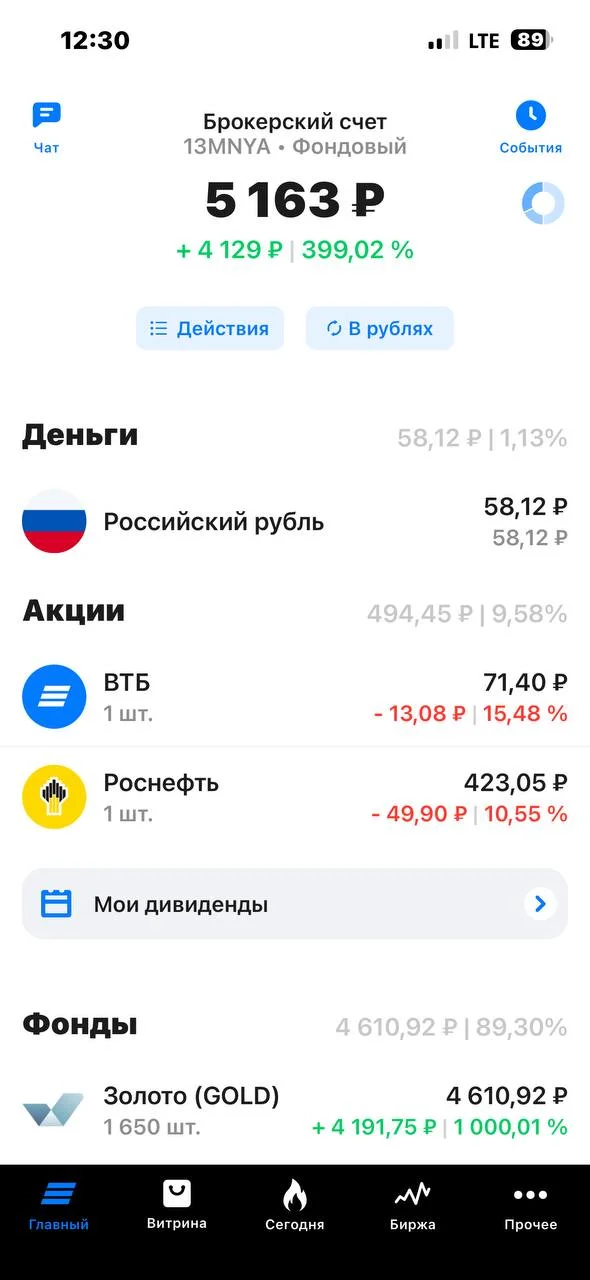

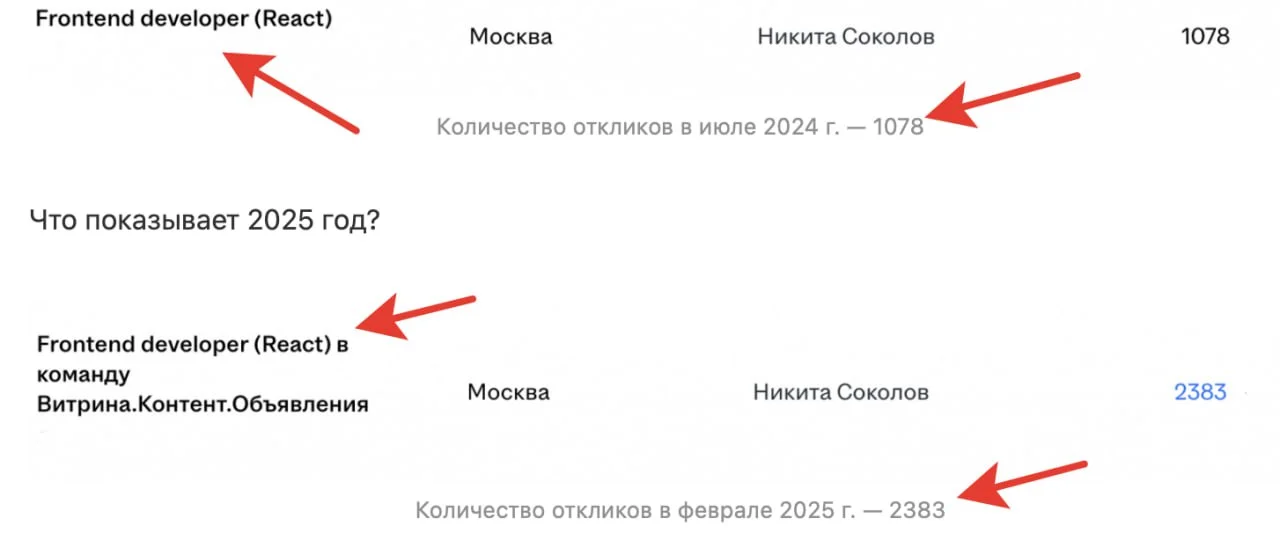

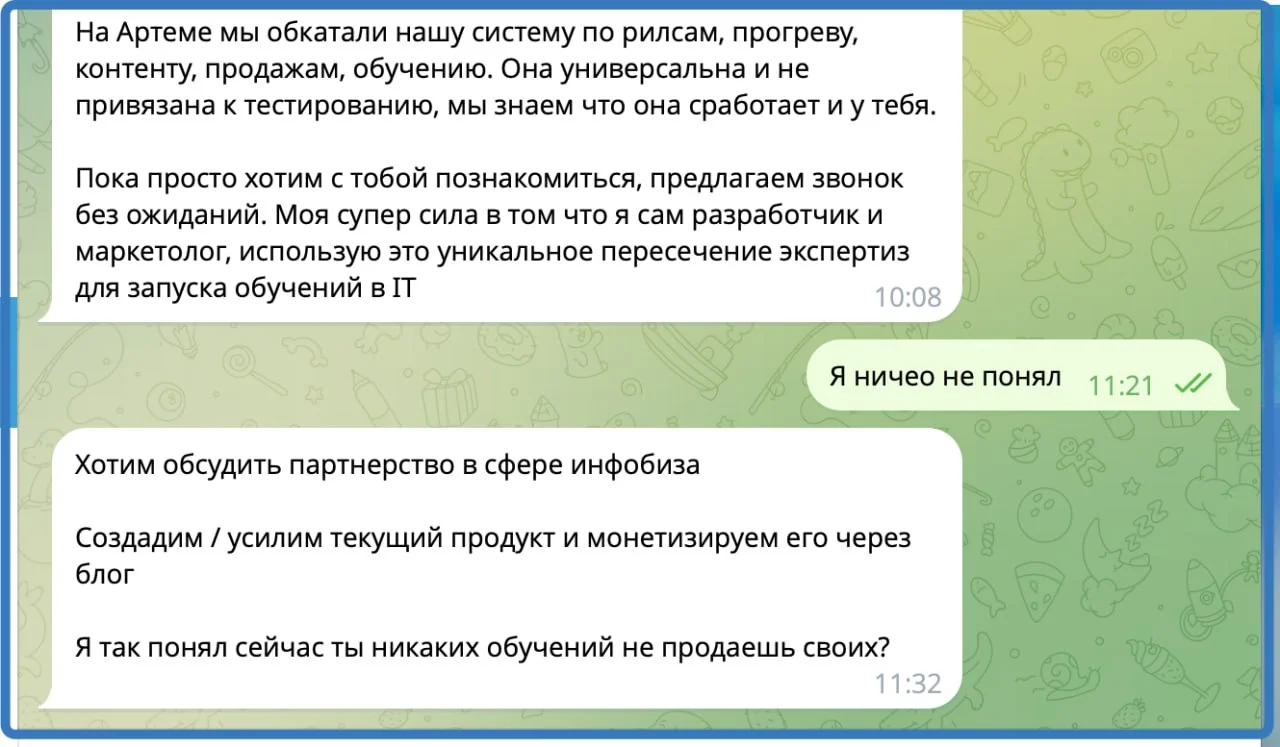

Русский ИТ бизнес