Не уверен, что мы бы в xmldatafeed.com вообще взялись бы за такую задачу - парсинг регулярны 300 000 сайтов. Можно, полагаю, использовать наши наработки в ИИ анализе, но это не быстро и будут баги (мы такое уже делаем, я вижу как тяжко идет).

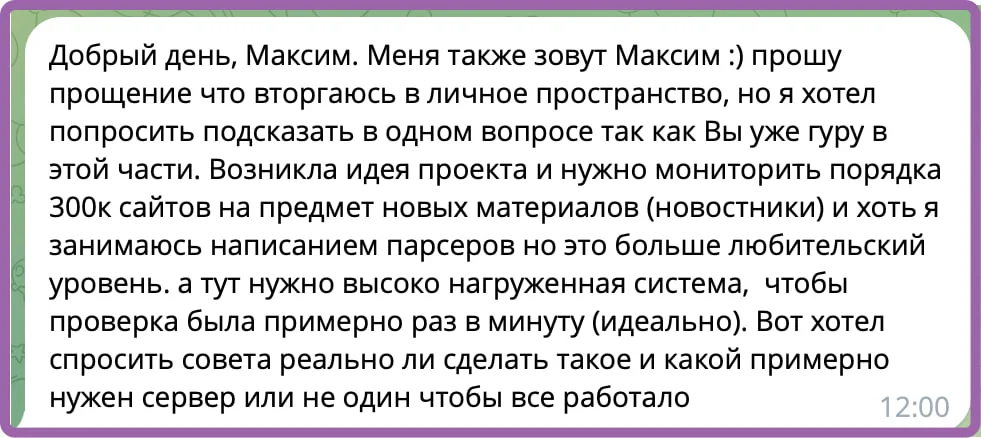

В общем почитайте на картинке, задача реально сложная, но занятная технически.

Русский ИТ бизнес

Русский ИТ бизнес 👨

Подписаться

Комментарии (0)

Я грит с чатгпт начал делать, но что-то не срослось, но все просто вы разберётесь. Спросил о бюджете. Бюджет 100€

Порекомендовал ему у гпт уточнить стоимость разработки и сроки.

В общем похоже уточнил. Так как больше его никто не видел 🤷

один в один задачу пытались поставить

И, как Вы верно заметили, есть ещё разметки JSON+LD и Schema.org

И да, парсинг для этого кейса тупиковая по костам техноложка