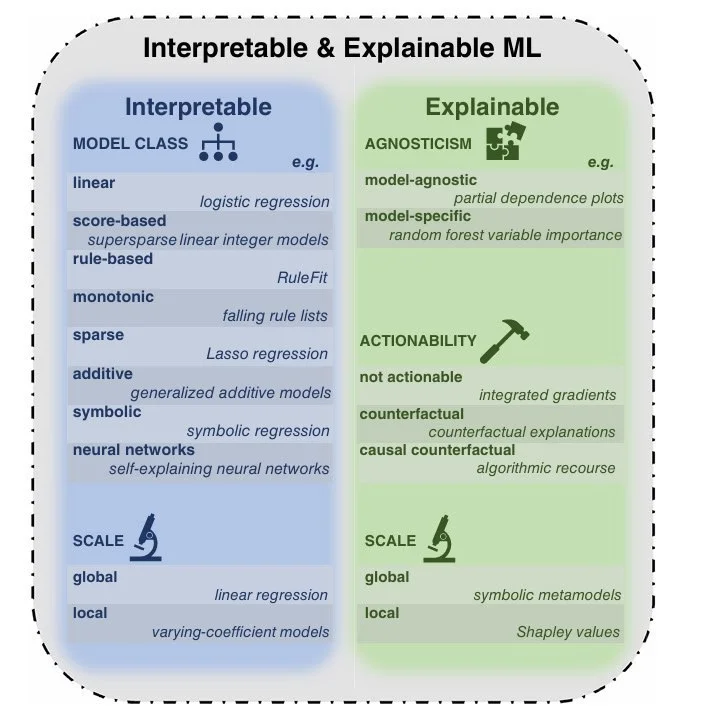

Тут на Хабре вышла отличная статья про объяснимый ИИ (XAI). Если кратко: мы всё чаще используем ИИ в критичных сферах - от медицины до юриспруденции, но до сих пор не понимаем, как они принимают решения :)

Проблема в двух словах:

- ИИ выдаёт brilliant-результаты, но не может внятно объяснить ход мыслей

- Методы вроде LIME, SHAP и контрфактуальных объяснений - это костыли, а не решение

- Регуляторы (типа AI Act в ЕС) уже требуют прозрачности

А я смотрю на это и думаю: мы создали цифрового оракула, который умнее нас, но не способен к рефлексии ... Особенно весело, когда ChatGPT генерит фейковые судебные дела с невозмутимым видом - классика "галлюцинаций" LLM!

Но договора ИИ неплохо анализирует, тут признаю.

Русский ИТ бизнес

Комментарии (0)

До человека ему ещё как раком до Парижа. 😉

Он очень ограничен во всём, что выходит за рамки его обучающих данных, и в этом его основная слабость.

А по сути, он зеркало, которое отражает пользователя. 😊

Каков вопрос, таков и ответ. :)) Но процессы мышления у него прикольные! 🤭

Но у человека нет границ для мышления, а у ИИ они ограничены датасетом и философскими взглядами разработчиков. 😉

Да и глубина проработки контекстов и выстраивания связей между различными элементами системы(систем) у человека намного превосходит способности ИИ. И разрыв огромный! 😊

ИИ лишь собирает ответ из тех данных, на которых обучен, и которые релевантны для пользователя.

Каждая эпоха несёт новую парадигму, т.е. новое мышление. И то, что вчера казалось монолитом в науке и технологиях, завтра будет вызывать улыбку. 😊

Помните принцип из кибернетики: Чем сложнее система, тем больше в ней слабых мест! 😉

Как можно осуждать чьи-то идеи, если даже не знаком с ними.

Я говорю лишь о своем опыте, не более того. 😉