Не знаю, как это запускать локально, ибо новые ИИ просто коллосы.

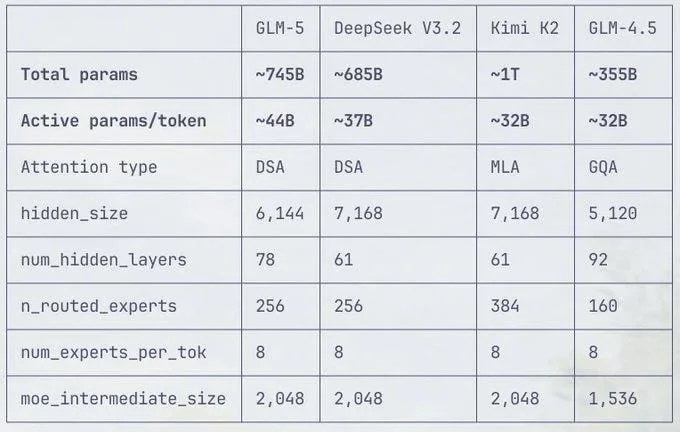

Судя по расчетам пользователей на основе кода (HuggingFace PR), общая база параметров GLM-5 составляет около 776 миллиардов (776B).

Чтобы запустить такую махину даже в сжатом виде (квантование 4-бит), потребуется более 400 ГБ видеопамяти (VRAM). Для этого нужно минимум 17–20 видеокарт RTX 3090/4090, что превращает «локальный» запуск в серверную задачу :)

В общем ИИ становятся умнее, но «входной билет» для их запуска дома подорожал до цены подержанного автомобиля в РФ.

Русский ИТ бизнес

Русский ИТ бизнес 👨

Подписаться

Комментарии (4)

Было бы круто посмотреть альтернативы подешевле за счёт оптимизаций и квантования