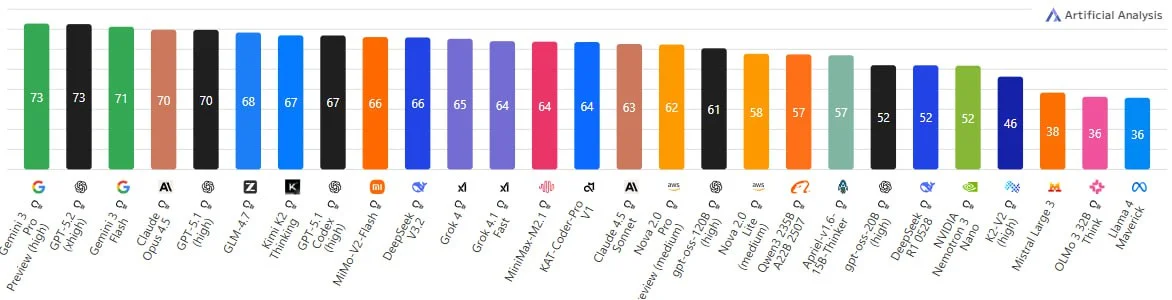

GLM 4.7 лучшая ИИ модель с открытым кодом. Чуть- чуть уступает проприетарным. Это ведь огромный прорыв, т.к. вы можете локально запускать могучую ИИ и не передавать данные "в облака".

Русский ИТ бизнес

Русский ИТ бизнес 👨

Подписаться

Комментарии (0)

И вот что мне выдало, если интересно:

В этом высказывании — ирония или сарказм, направленный на то, чтобы подчеркнуть, насколько дорого на самом деле обходится создание высокопроизводительной вычислительной системы на базе новейшего оборудования Apple, несмотря на кажущуюся простоту фразы «уже не дорого».

Разберём по частям:

- Mac Studio M4 Ultra — это гипотетическая (на декабрь 2025 года ещё не анонсированная) версия Mac Studio с чипом Apple M4 Ultra. На данный момент (декабрь 2025) Apple представила M3 Ultra, так что M4 Ultra — либо утечка, либо спекуляция.

- 4x Mac Studio M4 Ultra — означает покупку четырёх таких систем.

- 320 GPU-ядер — если предположить, что один M4 Ultra содержит около 80 GPU-ядер (как M3 Ultra имеет до 80), то 4 × 80 = 320.

- 2 ТБ памяти — вероятно, имеется в виду оперативная память (RAM). M3 Ultra поддерживает до 192 ГБ RAM, так что 2 ТБ (2048 ГБ) суммарно по 4 машинам — это фантастическая цифра, но не объединённая в один пул памяти. Важно: вы не можете просто «объединить» RAM четырёх Mac Studio в одну общую память — это технически невозможно без специализированного кластерного ПО и архитектуры, которую macOS не поддерживает.

- «За сущие копейки» — явная ирония. Даже одна топовая Mac Studio стоит от $8 000 до $10 000+. Четыре — это $32 000–$40 000+, плюс расходы на питание, охлаждение, сетевую инфраструктуру. Это очень дорого, особенно по сравнению с кластерами на базе Linux или решений от NVIDIA/AMD.

### Вывод:

Это саркастическое замечание, высмеивающее иллюзию доступности высокопроизводительных вычислений на потребительском оборудовании Apple. Автор подчёркивает, что даже при кажущейся простоте «просто купи четыре Mac’а» — это на самом деле чрезвычайно затратное и технически неэффективное решение для задач, требующих масштабируемой GPU- или RAM-мощности (например, машинное обучение, рендеринг и т.п.).

Если бы речь шла о реальных вычислениях — профессионалы чаще используют GPU-серверы на базе Linux с несколькими видеокартами NVIDIA (например, H100), которые и дешевле на вычисление, и позволяют реально объединять память и вычислительные ресурсы.

Опять же ryzen 395+ 1700 с платой , хватает для gpt-120

А вот для stable diffusion такое не канает, там надо память на одном устройстве

Но вот про Маки - надо изучать, Макс постянно находит примеры, я касался только картинок и по ним однозначно маки хуита, не тянут и близко за свою цену, ну а llm - возможно

Из того что выдаёт поиск, очень большой разбег в показаниях для одного и того же текста